在 Podman AI Lab 中启用 OpenVINO 推理

·4 分钟阅读

Podman AI Lab 简介

Podman AI Lab 是一个开源平台,旨在使用容器技术简化 AI 工作负载的部署、管理和实验。它提供了一个用户友好的界面,用于在本地或云端运行、测试和扩展 AI 模型,充分利用了 Podman 容器的强大功能和灵活性。

什么是 OpenVINO?

OpenVINO™(Open Visual Inference and Neural Network Optimization,开放视觉推理和神经网络优化)是英特尔开发的一个开源工具包,用于在各种硬件(包括 CPU、GPU 和专用加速器)上加速 AI 推理。它优化深度学习模型以实现快速、高效的推理,使其成为边缘和云 AI 应用的热门选择。

在 Podman AI Lab 中使用 OpenVINO

Podman AI Lab 现在支持 OpenVINO 作为推理提供程序。这意味着您可以:

- 在启动推理服务器或 playground 时选择一个与 OpenVINO 兼容的模型。

- 在支持的英特尔设备上享受硬件加速推理带来的好处。

- 轻松地在不同的推理提供程序(例如,llama-cpp、OpenVINO)之间切换,以进行基准测试和兼容性测试。

警告

此功能仅在基于英特尔的系统上可用,因为 OpenVINO 是为英特尔硬件优化的。如果您使用的是非英特尔系统,您将无法使用 OpenVINO 作为推理提供程序。

如何使用

- 启动 Podman AI Lab 并导航到模型部署或 playground 部分。

- 在配置您的模型时,选择一个与 OpenVINO 兼容的模型。

- 启动推理服务器或 playground。

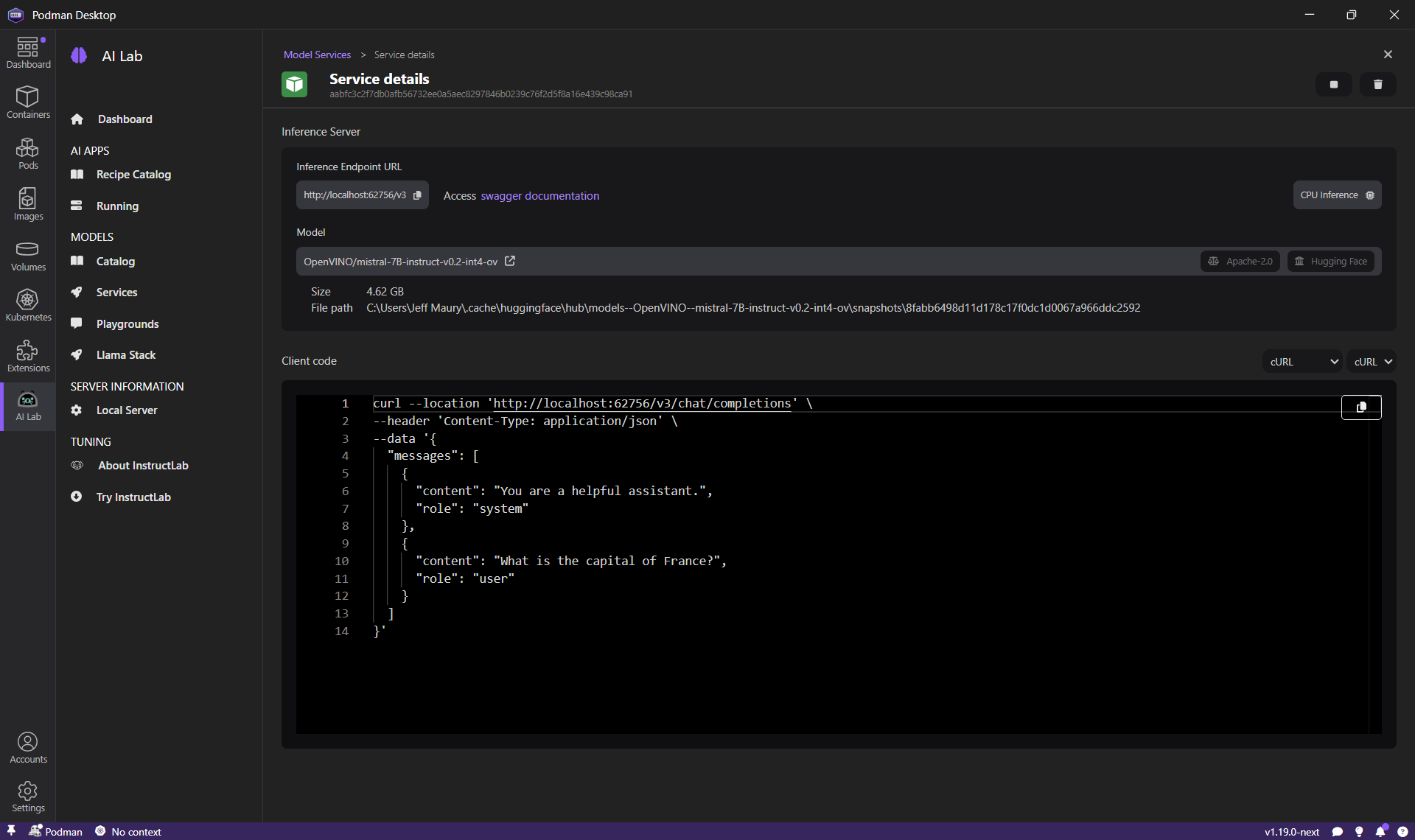

启动 OpenVINO 推理服务器

- 点击导航栏中的 Podman AI Lab 图标。

- 在 Podman AI Lab 导航栏中,点击 模型 > 服务 菜单项。

- 点击右上角的 新建模型服务 按钮。

- 在 模型 列表中选择一个与 OpenVINO 兼容的模型(例如 OpenVINO/mistral-7B-instruct-v0.2-int4-ov),然后点击 创建服务 按钮。

- 该模型的推理服务器正在启动,稍等片刻后,点击 打开服务详情 按钮。

使用终端 shell,执行给定的 curl 命令并查看推理结果输出。

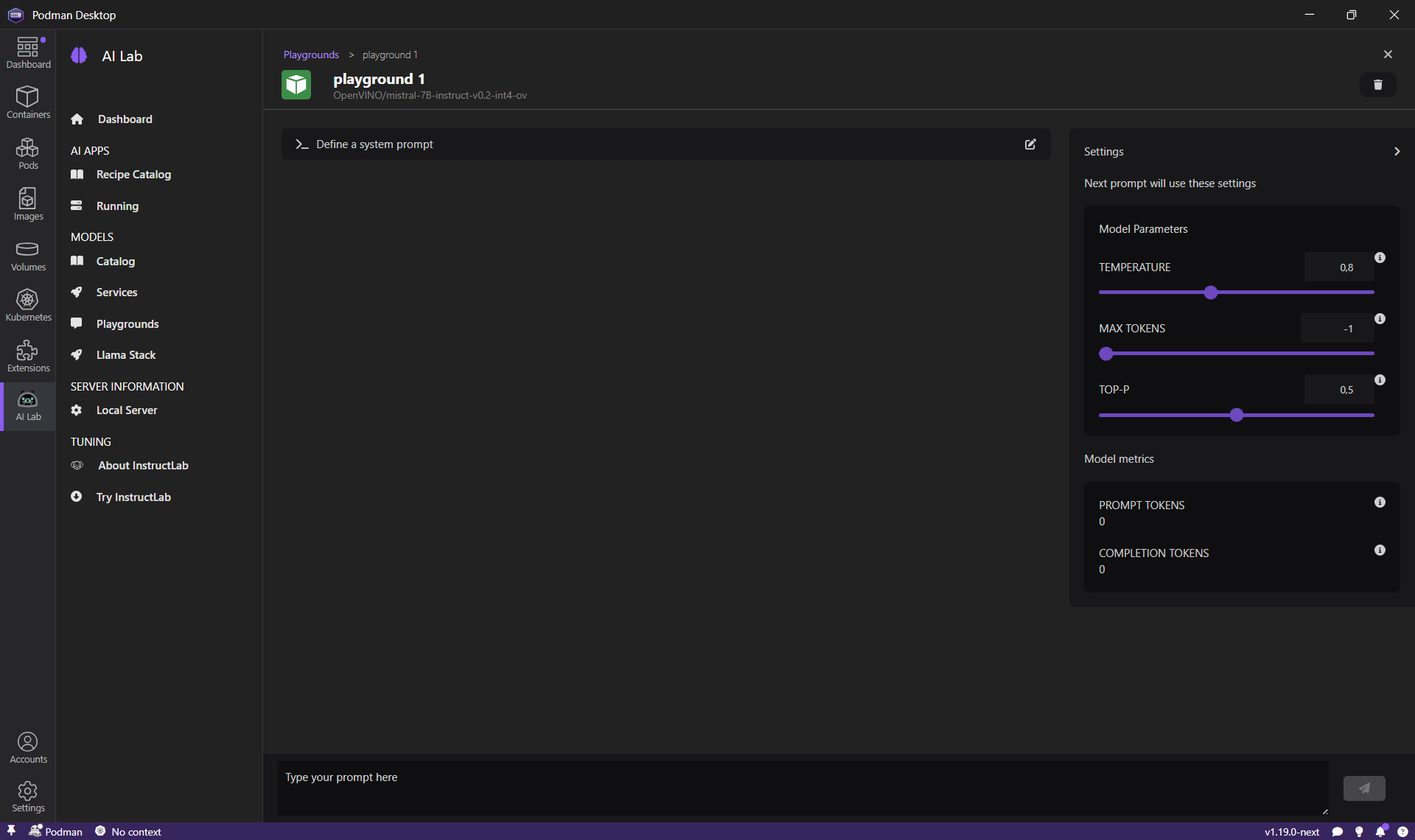

使用 OpenVINO 兼容模型启动一个实验环境

- 点击导航栏中的 Podman AI Lab 图标。

- 在 Podman AI Lab 导航栏中,点击 模型 > Playgrounds 菜单项。

- 点击右上角的 新建 Playground 按钮。

- 在 模型 列表中选择一个与 OpenVINO 兼容的模型(例如 OpenVINO/mistral-7B-instruct-v0.2-int4-ov),然后点击 创建 Playground 按钮。

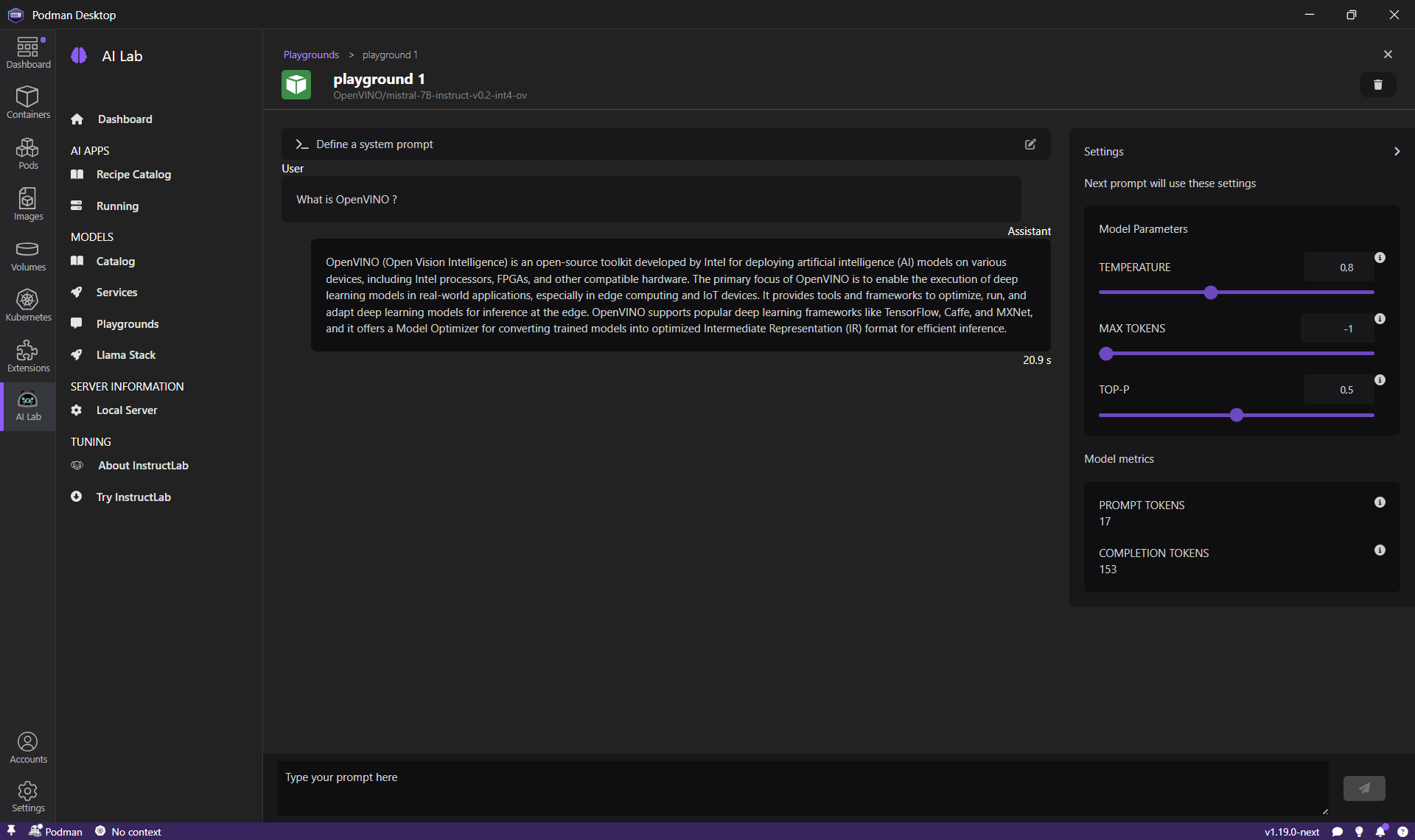

- 该模型的 playground 正在启动,稍等片刻后,将显示一个聊天界面。

在提示符中输入“What is OpenVINO ?”,然后点击 发送 按钮。OpenVINO 模型将回复一个答案。

与 OpenShift AI + OpenVINO 的一致性

在 Podman AI Lab 中使用 OpenVINO 的一个关键优势是,当将工作负载过渡到 OpenShift AI 时,它带来了一致性。这两个平台现在都支持 OpenVINO,确保:

- 在 Podman AI Lab 中本地测试和优化的模型,在部署到 OpenShift AI 时将表现出相同的行为。

- 您可以维持从开发到生产的统一工作流,减少意外情况和集成问题。

- 性能优化和硬件加速在不同环境中得以保留。

结论

通过启用 OpenVINO 作为推理提供程序,Podman AI Lab 使用户能够在本地和云端利用高性能的 AI 推理,并在 OpenShift AI 等平台上获得一致的体验。这种集成简化了 AI 开发生命周期,并为部署高效、可扩展的 AI 解决方案开辟了新的可能性。